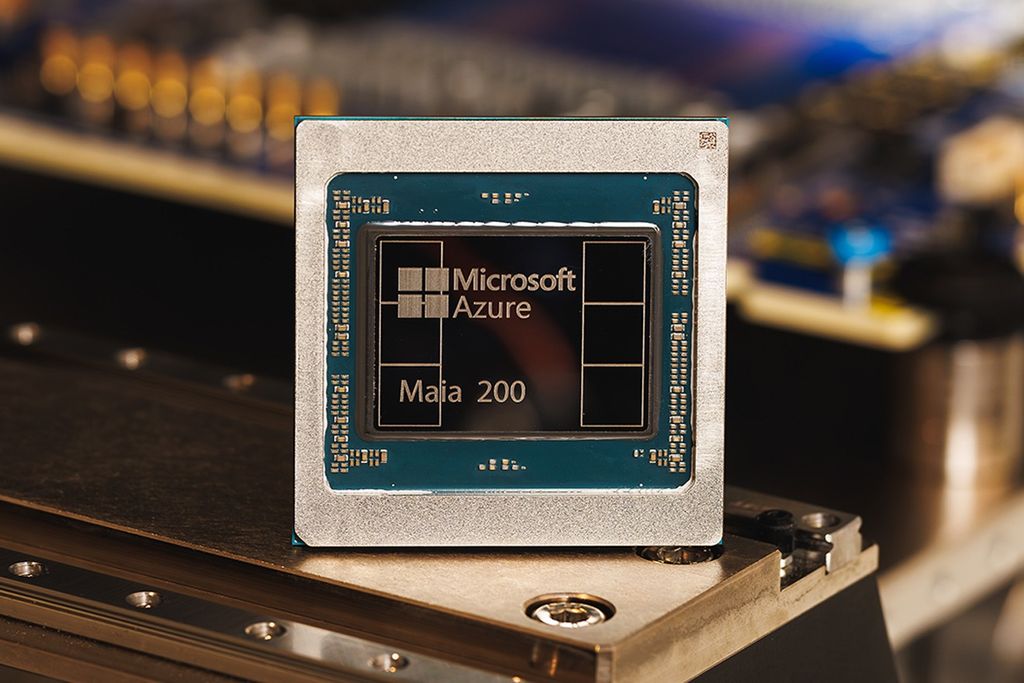

Microsoft, kendi bünyesinde geliştirdiği ilk yapay zekâ çipinin devamı niteliğindeki Maia 200’ü resmen duyurdu. TSMC’nin 3 nanometrelik üretim süreciyle geliştirilen yeni hızlandırıcı, şirketin bulut ve yapay zekâ altyapısında daha yüksek performans ve verimlilik hedeflerinin merkezinde yer alıyor. Microsoft tarafından yapılan açıklamalara göre, Maia 200, özellikle büyük ölçekli yapay zekâ modellerinin eğitimi ve çıkarımı için tasarlanmış bir mimari sunuyor. Şirket, bu donanımın mevcut rakip çözümlerle karşılaştırıldığında dikkat çekici performans değerlerine ulaştığını ifade ediyor. Yeni çip, Azure veri merkezlerinde kademeli olarak devreye alınmaya başlandı.

Maia 200, FP4 hesaplamalarında Amazon’un üçüncü nesil Trainium hızlandırıcısına kıyasla üç kata kadar daha yüksek performans sunuyor. FP8 tarafında ise Google’ın yedinci nesil TPU çözümlerinin üzerinde bir seviyeye ulaşıldığı belirtiliyor. Her bir Maia 200 yongasında 100 milyarın üzerinde transistör yer alıyor ve bu yapı, özellikle büyük dil modelleri ile çok modlu yapay zekâ sistemlerinin ihtiyaç duyduğu yoğun hesaplama yüklerini karşılamaya odaklanıyor. Microsoft Cloud ve Yapay Zekâ Grubu Başkan Yardımcısı Scott Guthrie, Maia 200’ün günümüzde kullanılan en büyük modelleri rahatlıkla çalıştırabildiğini, buna ek olarak gelecekte daha büyük modeller için de geniş bir kapasite sunduğunu dile getiriyor. Her şeye rağmen şirket, teknik detayların tamamını paylaşmaktan kaçınarak mimariyi rekabetçi bir çerçevede konumlandırmayı tercih ediyor.

Maia 200, Microsoft Azure ve Copilot altyapısının merkezine yerleşiyor

Microsoft, Maia 200 çiplerini öncelikli olarak OpenAI tarafından geliştirilen GPT-5.2 modeli başta olmak üzere, Microsoft Foundry ve Microsoft 365 Copilot hizmetlerinde kullanmayı planlıyor. Bu tercihin ardında, donanım ile yazılım arasındaki entegrasyonun daha sıkı bir şekilde kontrol edilebilmesi yatıyor. Guthrie’nin paylaştığı bilgilere göre Maia 200, Microsoft’un bugüne kadar devreye aldığı en verimli çıkarım sistemlerinden biri konumunda bulunuyor. Şirket, yeni çipin mevcut donanım altyapısına kıyasla dolar başına performansta yaklaşık yüzde 30 oranında bir iyileşme sağladığını vurguluyor. Buna rağmen, enerji tüketimi ve soğutma gereksinimleri gibi alanlarda net sayısal veriler henüz açıklanmış değil.

Microsoft’un bu alandaki yaklaşımı, Maia 100’ün 2023 yılında kullanıma sunulduğu döneme kıyasla daha iddialı bir tablo çiziyor. O dönemde şirket, Amazon ve Google gibi rakiplerle doğrudan performans karşılaştırmalarından kaçınmıştı. Öte yandan günümüzde rekabetin daha da sertleştiği görülüyor. Amazon’un Nvidia ile birlikte geliştirdiği Trainium4 çipi üzerinde çalıştığı ve bu donanımı NVLink 6 ile MGX raf mimarisiyle entegre etmeyi hedeflediği biliniyor. Google cephesinde ise yeni nesil TPU’ların yapay zekâ eğitim ve çıkarım süreçlerinde daha yüksek verimlilik sunması bekleniyor.

Maia 200’ün ilk kullanıcıları arasında Microsoft’un Superintelligence ekibi yer alıyor. Bunun yanında şirket, akademisyenler, bağımsız geliştiriciler, yapay zekâ laboratuvarları ve açık kaynak model projeleri için erken erişim programı başlattı. Bu kapsamda Maia 200 yazılım geliştirme kiti sınırlı bir ön izleme süreciyle erişime açılıyor. İlk dağıtım Azure’un ABD Central veri merkezi bölgesinde başladı ve ilerleyen dönemlerde farklı coğrafyalara yayılması planlanıyor.

Teknoblog, teknoloji gündemini farklı platformlarda düzenli biçimde paylaşıyor. WhatsApp kanalında öne çıkan haberleri anlık olarak aktarıyor, Google Haberler üzerinden güncel içerikleri sunuyor, Instagram ve X hesaplarında dikkat çeken başlıkları özetliyor, YouTube kanalında ise ürün incelemeleri ve detaylı anlatımlarla içeriği tamamlıyor.