OpenAI, yerel donanımda çalışabilen ve tamamen ücretsiz olan yeni dil modeli ailesi gpt-oss’i yayımladı. Bu modeller, kim tarafından, ne zaman ve hangi cihazlarla kullanılabileceği gibi temel sorulara yanıt veriyor ve geliştiricilere açık kaynak seçenek sunuyor.

Modellerin en dikkat çeken özelliği, gelişmiş bir yapay zeka sisteminin ilk kez bu denli kolay erişilebilir hale gelmesi. gpt-oss-20b, 16 GB belleğe sahip bir dizüstü bilgisayarda çalışabiliyor. Daha güçlü donanımlara hitap eden gpt-oss-120b modeli ise 80 GB belleği olan bir GPU ile kullanılabiliyor. Her iki model de Apache 2.0 lisansıyla açık kaynak olarak paylaşıldı. Böylece yazılım geliştiriciler, kurumlar ve bireysel kullanıcılar bu modelleri kendi altyapılarında özelleştirip kullanabiliyor. Herhangi bir bulut hizmetine bağlı kalmadan yerel kullanım imkânı sunuluyor.

OpenAI’ın bu hamlesi, bugüne dek sadece büyük veri merkezlerinde çalışan dil modellerinin artık daha küçük cihazlarda da kullanılabileceğini gösteriyor. gpt-oss modelleri, sadece kaynak kodlarıyla değil, aynı zamanda model ağırlıklarıyla birlikte indirilebiliyor. Bu durum, özellikle veri gizliliği ve özel ağlarda çalışma gereksinimi duyan sektörler için önem taşıyor. Kullanıcılar kendi sistemlerinde modelin nasıl çalıştığını denetleyebiliyor. Üstelik modeller, masaüstü ve dizüstü sistemlerde doğrudan çalışacak biçimde optimize edildi.

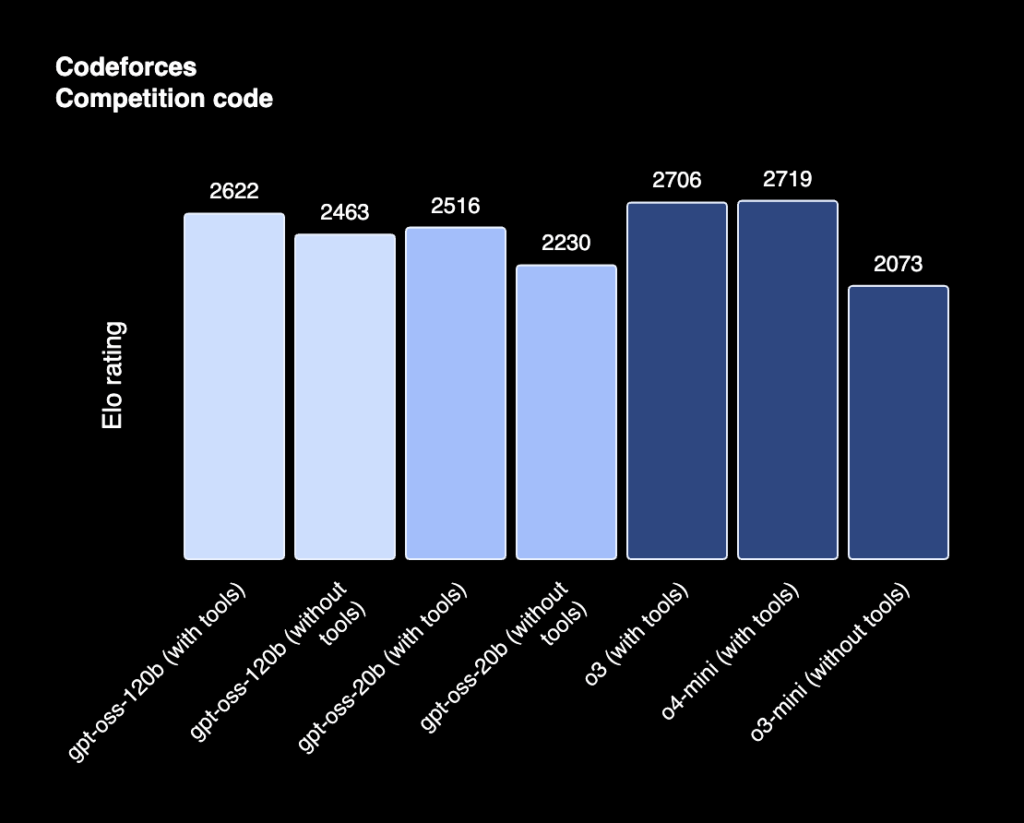

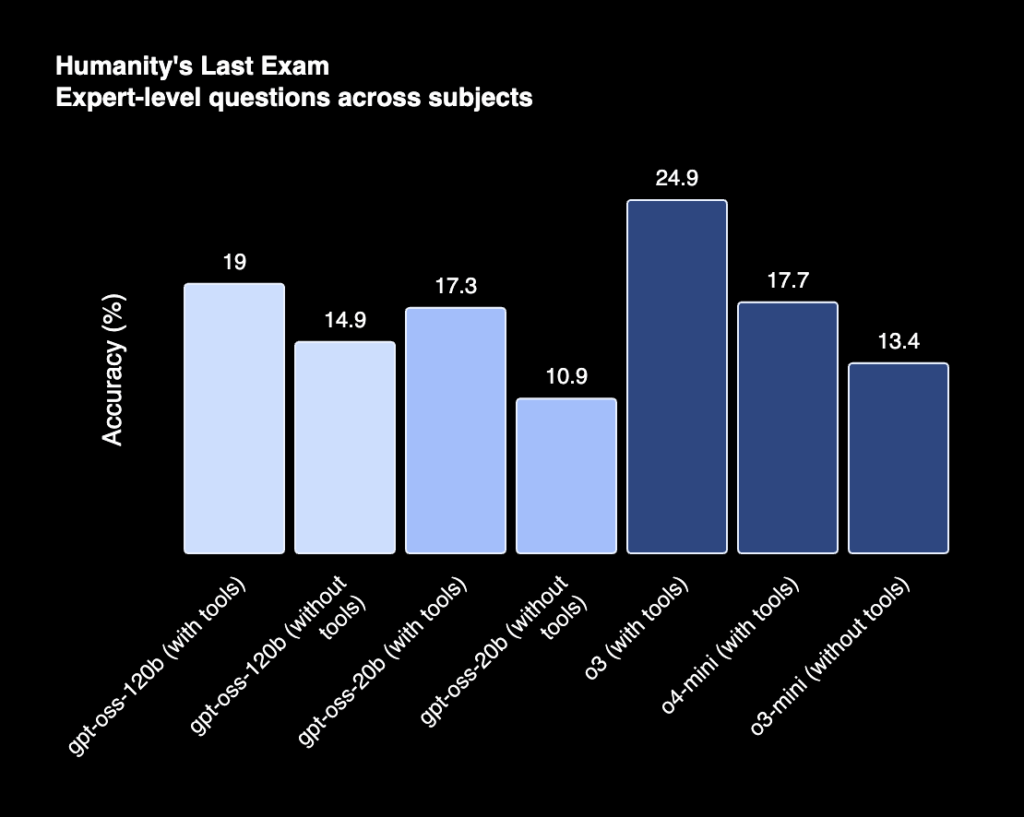

gpt-oss-20b modeli, düşük sistem gereksinimiyle öne çıkıyor. Bu modelin sunduğu 16 GB RAM yeterliliği, birçok modern dizüstü bilgisayarda kullanılabilmesini sağlıyor. Modelin başarımı, OpenAI’ın daha önce tanıttığı o3-mini modeline yakın değerlere ulaşıyor. Yaygın testlerde, kodlama ve matematik gibi alanlarda benzer doğruluk oranları ölçülmüş durumda. HealthBench ve AIME gibi özel testlerde ise gpt-oss-20b, bazı alanlarda o3-mini’yi geride bırakıyor.

gpt-oss-120b modeli tek bir GPU ile yüksek başarı sunabiliyor

Daha büyük ölçekli kullanım için geliştirilen gpt-oss-120b modeli ise 117 milyar parametreye sahip. Bu model, yalnızca 5.1 milyar aktif parametreyle çalışacak şekilde tasarlandı. Böylece büyük modellerin çıkardığı yüksek donanım gereksinimi sınırlı tutulmuş oldu. 80 GB belleğe sahip tek bir grafik işlemci, bu modelin tam kapasiteyle çalışmasına olanak sağlıyor. gpt-oss-120b, OpenAI’ın tescilli modellerinden biri olan o4-mini ile çeşitli değerlendirmelerde benzer sonuçlar veriyor.

Model mimarisi Transformer tabanlı olarak yapılandırıldı. Parametrelerin yalnızca küçük bir bölümü işlem sırasında aktif hale geliyor. Bu yapı, mixture-of-experts (MoE) olarak bilinen yöntemle oluşturulmuş. Her iki modelde de bağlam uzunluğu 128 bin token’a kadar çıkabiliyor. Rotary Positional Embedding (RoPE) ve gruplanmış multi-query attention gibi teknikler kullanılarak verimlilik artırılmış durumda.

OpenAI, modellerin eğitiminde çoğunlukla İngilizce ve metin tabanlı verilerden oluşan bir veri kümesi kullandığını belirtiyor. Bu veri setinde bilimsel içerik, yazılım verileri ve genel bilgi konuları ön planda. Tokenleştirme süreci için o200k_harmony adlı özel bir yapı tercih edilmiş. Bu sistem, GPT‑4o modellerinde kullanılan token yapısının genişletilmiş bir versiyonu.

Her iki model de çıkarım süreçlerinde farklı düzeyde akıl yürütme becerileri sunuyor. Geliştiriciler, modellerin cevabı oluştururken harcadığı “düşünme süresi”ni üç seviyede (düşük, orta, yüksek) belirleyebiliyor. Bu özellik, gecikmeye duyarlı uygulamalarda büyük avantaj sağlıyor. Karmaşık analizlerde daha uzun ve detaylı cevaplar alınabilirken, sade görevlerde model daha hızlı çalışıyor.

TauBench, HealthBench ve GPQA gibi karşılaştırmalı testlerde gpt-oss modellerinin başarımı oldukça kapsamlı şekilde ölçüldü. gpt-oss-120b, bazı senaryolarda tescilli GPT-4o modelinden daha yüksek doğruluk oranlarıyla sonuç verdi. Özellikle sağlık ve rekabet düzeyindeki matematik sorularında bu durum daha belirgin.

Ayrıca OpenAI, model güvenliğine özel bir önem verildiğini belirtiyor. Eğitim sürecinde zararlı içeriklerin filtrelenmesinin yanı sıra, modellerin kötüye kullanım senaryolarına karşı özel testlerden geçtiği ifade ediliyor. Şirket, bu değerlendirme sürecine dış uzmanları da dahil etmiş. Bu sayede açık modellerin güvenlik seviyesinin artırılması hedeflenmiş.

OpenAI, modellerin kendi bilgisayarında çalıştırılabilmesini isteyen geliştiriciler için örnek kodlar ve kullanım kılavuzları da paylaşıyor. Python ve Rust platformları için hazırlanmış harmony adı verilen çıkış formatı da açık şekilde yayımlandı. Modeller, Apple’ın Metal platformunda da çalışacak şekilde optimize edilmiş durumda. Bunun yanında Hugging Face, Azure, AWS ve Vercel gibi sağlayıcılarda da dağıtım seçenekleri yer alıyor.

gpt-oss modelleri, Microsoft’un da desteğiyle Windows kullanıcılarına yönelik olarak GPU ile hızlandırılmış şekilde sunuluyor. ONNX Runtime üzerinden çalışan bu sürümler, Foundry Local ve Visual Studio Code için geliştirilen AI Toolkit üzerinden erişilebilir hale getirildi. Böylece Windows geliştiricileri yerel sistemlerinde modelle doğrudan çalışabiliyor.

Geliştiriciler, modelleri ister kendi donanımlarında çalıştırabiliyor, isterlerse modelleri çeşitli bulut platformları üzerinde özelleştirerek kullanabiliyor. gpt-oss modelleri, farklı gereksinimlere göre şekillendirilebilecek esnek bir altyapı sunuyor. Bunun yanında, yerel gizlilik ve bağımsız geliştirme ihtiyacına yanıt veren bir çözüm olarak konumlanıyor.

OpenAI’nin yayımladığı gpt-oss serisi, ücretsiz, açık kaynaklı ve dizüstü bilgisayarda çalışabilir yapısıyla öne çıkıyor. Bu durum, yapay zeka teknolojilerinin daha fazla geliştiriciye ulaşmasının önünü açıyor. Böylelikle bireysel kullanıcılar ve küçük ölçekli ekipler, yüksek donanım yatırımı yapmadan bu modellerden faydalanabiliyor.